Une question qui reviens sur le tapis de plus en plus souvent est la question de la protection de la vie privée sur Internet. Le Web 2.0, les réseaux sociaux ont changé le comportement des internautes ces dernières années mais pas forcement dans le bon sens. Le grand public utilise joyeusement tout les nouveaux outils mis a leur dispositions (Facebook, MySpace, Gmail, FlickR,...) sans forcément se soucier des implications qui peuvent se cacher derrière. Les utilisateurs de logiciels libres les plus engagés auront quand à eu une attitude de méfiance pouvant aller au rejet le plus total pour les cas les plus extrêmes.

Les peurs liées aux applications web sont justifiées : Dans la très grande majorité il s'agit de logiciels propriétaires qui contrairement aux logiciels traditionnels, s'exécutent sur un serveur distant au lieu de s'exécuter sur votre machine. Sur ce point la, il n'y a aucune raison de différencier les clients lourds des applications web : un logiciel est conçu pour traiter des données, et que ce que soit votre processeur ou un serveur distant qui s'en occupe est strictement la même chose : vous ne possédez pas de contrôle sur vos données. Pire encore, vous n'êtes plus propriétaires de vos données puisqu'elles ne sont plus stockées sur votre disque dur.

Et inutile de séparer les 'gentils' SourceForge ou Launchpad des 'méchants' Google et Facebook , ils fonctionnent sur le même principe même si l'ont peut spéculer de manière incertaine sur leur motivations par rapport a l'utilisateur final. Et même quand le code source de Launchpad sera ouvert, cela ne changera pas grand chose en pratique. Vos données ne seront pas hébergées sur votre machine et il n'y aura aucun moyen d'aller vérifier que les sources exécutées correspondent en tout point a celles publiées.

Doit on pour autant rejeter en masses tout les outils collaboratifs et toutes les applications du Web 2.0 ? Il est évident que non ! J'irais jusqu'à qualifier cette attitude de paranoïaque, hermétique et stupide.

Sur Internet, c'est avant tout l'utilisateur qui doit être conscient de ses actions, du fait qu'il publie des données personnelles (et non privées, mais j'y reviendrais). L'internaute doit faire le choix de confier certaines données a un acteur tiers afin d'en assurer la visibilité par le plus grand nombre.

Avant de continuer je voudrais faire une parenthèse pour mentionner la conférence de Benjamin Bayard intitulée "Internet libre ou Minitel 2.0" qui cerne très bien le sujet.

Le cas de Marc L. : données personnelles et privées

Le magazine Le Tigre à récemment effectué une expérience très intéressante : On prends un individu lambda choisi au hasard parmi les utilisateurs des réseaux sociaux et on fouille le web a la recherche d'informations le concernant afin d'aboutir à un résumé de sa vie personnelle. Un vrai travail de détective en quelque sorte. Quand Marc L. a pris connaissance de l'article il est est tombé des nues car il ne se rendait surement pas compte à quel point sa vie était exposée sur le net.

Pourtant , le magazine Le Tigre n'a rien fait de mal, il s'est contenter de rassembler des informations visibles par tout le monde et d'en faire la synthèse. Le problème viens en totalité de la 'victime' et de son manque de prise de conscience vis à vis de ses actes sur le Web.

Il n'est pas nécessaire pour autant nécessaire se vivre caché mais le point primordial est de faire la différence entre données personnelles et donnés privées. Les données personnelles sont nominatives, par exemple l'affichage de votre adresse sur les pages blanches, ou le nom des bloggeurs sur Planet April. Le fait d'avoir des données personnelles sur la toile n'est pas un inconvénient, loin de la. Cela nous offre une visibilité par tous, nos 15 minutes de gloire en quelque sorte. C'est a mon avis un élément important et bouleversant du comportement de notre société. Auparavant seule les personnalités sélectionnées par les médias avaient droit a une reconnaissance et une renommée, avec Internet c'en est fini : chacun peut montrer de quoi il est capable sans avoir a subir de discriminations. Espérons que ce changement contribuera a terme à réduire le culte de la personnalité dont jouissent quelques privilégiés choisis par les médias traditionnels.

Les données privées quand à elles sont celles qui n'ont aucune raison d'être vues par d'autres personnes que vos proches, ou des personnes que vous choisissez au cas par cas. Cela signifie qu'il est totalement stupide de faire confiance a un acteur tel que Facebook pour diffuser de telles informations en se disant que son profil ne sera visité que par des personnes de confiance.

D'une manière générale on peut dire que toute information que vous ne souhaiteriez pas voir figurer dans le fichier Edvige, ou dans les pages Blanches ne doit être publiée sur le Web.

Les logiciels propriétaires du Web n'ont aucun défaut de ce point de vue, si Facebook vends vos données a des publicitaires, c'est VOTRE faute, si Google anaylse vos mails de GMail VOUS êtes responsables, si Microsoft censure vos conversations MSN, VOUS ne pouvez vous en prendre qu'a vous même. Personne ne vous oblige a publier telle ou telle information sur le web public et la confiance que vous accordez aux acteurs qui gèrent vos données ne doit jamais dépasser la valeur de ces informations.

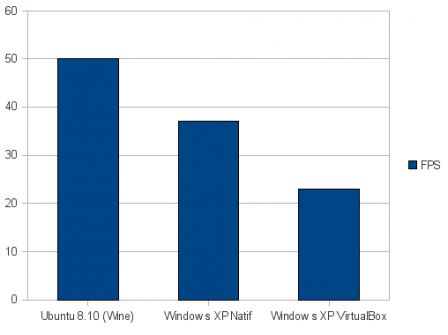

Enfin quand je dit que vous êtes responsable de vos agissements sur le net, c'est en théorie bien sur... Dans la réalité, il y a un gros travail de sensibilisation a faire chez les internautes pour contrer le sentiment de mise en confiance qu'offre délibérément les gros acteurs du Web. C'est triste a dire mais il y a eu une réelle régression faite ces dernières années sur l'attitude à avoir sur Internet. Lorsqu'Internet n'était peuplé que de geeks, il existait une réelle séparation entre les communications publiques et privées, aujourd'hui tout est en train de se confondre car les outils propriétaires offrent un confort d'utilisation formidable alors que les outils utilisés traditionnellement n'ont pas bougé en 20 ans alors que le web accueille de plus en plus de nouveau venus néophytes.

Le réseau sous 4 angles différents

On peut voir Internet comme un échange entre un internaute et un ou plusieurs autres internautes a l'autre bout du tuyau. Ces communications peuvent être soit publiques, soit privées. Un émetteur, un destinataire, privé ou public : cela donne 4 configurations différentes.

Il est important de préciser que les communications privées doivent l'être en tout point de la chaine de communication, car vous n'êtes pas sans savoir que les gouvernements souhaitent contrôler le traffic (DADVSI, rapport Olivennes, etc...) et qu'un transfert peut être intercepté à n'importe quel endroit de la chaine.

1. Public - public

Inutile de s'étendre longuement sur ce cas, c'est celui que vous connaissez tous car il est utilisé dans 99% des cas : surf sur le Web, conversations sur IRC ou MSN, échange de mails, P2P non crypté, etc...

2. Public - privé

C'est une configuration a part et qui ne nous intéresse pas dans le cas présent : vous essayez d'intercepter une communication privée et de la décrypter: c'est du cracking. En revanche nous souhaitons nous protéger de ce genre d'attaques et c'est pour cela que nos communications privées doivent l'être réellement et avec des cryptages forts.

3. Privé - public

Vous souhaitez masquer votre identité pour accéder a des données disponibles sur Internet ou pour publier des données sans dévoiler votre identité. Vous pouvez utiliser un serveur proxy anonyme si vous lui faites confiance ou surfer hors de votre domicile ou de votre lieu de travail en n'utilisant aucune information qui puisse vous identifier (login, adresse mail, adresse MAC de votre carte WIFI ...).

4. Privé - privé

C'est a l'heure actuelle le domaine le plus important à développer, Les données doivent sortir de votre carte réseau en étant chiffrées et être déchiffrées chez l'interlocuteur. De nombreux outils et protocoles permettent cela : SSL (HTTPS, FTPS), SSH (connection directe, tunnels, VPN ), clés PGP ou GPG, réseaux friend2friend.

Il est très important de se focaliser sur le dernier point pour que le net pour que le net soit la propriété des internautes et non de quelques sociétés et des gouvernements. Comme je l'ai dit précédemment les outils nécessaires existent depuis plus de 20 ans, il s'agit maintenant de les rendre accessible au grand public comme le sont les outils existants pour le Web 2.0.

Internet a été crée par la communauté du logiciel libre et il est en train de se faire bouffer par des corporations qui ne méritent pas notre confiance même si elles proposent des services avantageux et confortables qui peuvent être utilisés a bon escient. La communauté du logiciel libre doit reprendre la main sur le transfert de données privées et ne pas rester immobile en tombant dans la paranoïa la plus complète.

.png)